#include

#include

#include

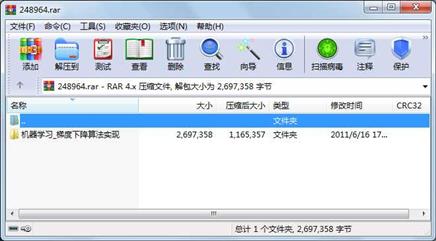

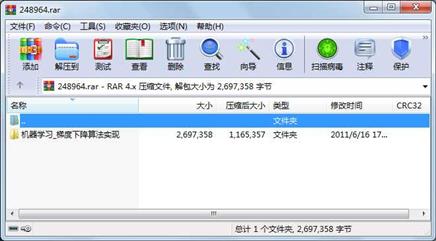

属性 大小 日期 时间 名称

----------- --------- ---------- ----- ----

文件 4671 2011-06-16 16:39 机器学习_梯度下降算法实现\gradient.cpp

文件 536475 1997-11-17 18:11 机器学习_梯度下降算法实现\test.dat

文件 2154343 1997-11-17 18:12 机器学习_梯度下降算法实现\train.dat

文件 1869 2011-06-16 17:22 机器学习_梯度下降算法实现\实验报告.txt

目录 0 2011-06-16 17:22 机器学习_梯度下降算法实现

----------- --------- ---------- ----- ----

2697358 5

川公网安备 51152502000135号

川公网安备 51152502000135号

评论

共有 条评论