资源简介

中文自动分词

1. 使用任意分词方法实现汉语自动分词;

2. 给出至少1000个句子的分词结果(以附件形式);

3. 计算出分词结果的正确率,并给出计算依据;

4. 用实例说明所用分词方法分别对“交叉歧义”和“组合歧义”的处理能力;

5. 提交实验报告,给出详细实验过程和结果;提交源代码和可执行程序。

代码片段和文件信息

# -*- coding: utf-8 -*-

import jieba

import codecs

with open(‘input.txt‘ ‘r‘) as f:

for line in f:

seg = jieba.cut(line.strip() cut_all = False)

s= ‘ ‘.join(seg)

m=list(s)

with open(‘source.txt‘‘a+‘)as f:

for word in m:

f.write(word.encode(‘utf-8‘))

f.write(‘\n‘)

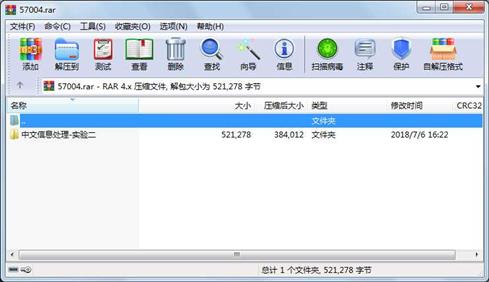

属性 大小 日期 时间 名称

----------- --------- ---------- ----- ----

文件 55749 2018-05-19 23:21 中文信息处理-实验二\1.txt

文件 56251 2018-05-19 23:21 中文信息处理-实验二\2.txt

文件 32579 2018-05-19 23:21 中文信息处理-实验二\source.txt

文件 357 2018-05-24 15:18 中文信息处理-实验二\work2.py

文件 534 2018-05-19 23:21 中文信息处理-实验二\work22.py

文件 375808 2018-07-06 16:21 中文信息处理-实验二\中文信息处理-实验二.doc

目录 0 2018-07-06 16:22 中文信息处理-实验二

----------- --------- ---------- ----- ----

521278 7

- 上一篇:Electron - 旋转的小尾巴

- 下一篇:OpenStack平台搭建

相关资源

- CVSNT 完整覆盖版防TortoiseCVS中文乱码

- 《Visual Prolog 基础类》 中文参考.chm

- STM32中文资料

- 电脑卡西欧计算器 fx-991CN X Emulator19中

- Rtx51_tiny_RTOS中文版.pdf

- Servlet API中文文档

- 组态王驱动开发包3.0.0.7(中文)

- 思科(CISCO) 2960 中文手册

- Speex手册中文版

- 马尔科夫 蒙特卡罗方法.rar 中文版

- arcgis 10.1 中文环境安装包

- 哈工大的高等电磁学电磁场课件

- openssl 简介(中文)

- 中文转化unicoder码的方法

- ModelSim全套中文手册ModelSim SE6.0C

- Linux From Scratch 中文手册

- 应用密码学 中文.rar

- 将数字转为中文金额的大写方式(C

- Todolist(最佳中文版时间管理工具)

- Macromedia Fireworks V8.0 简体中文版

- Origin2019最新中文版用户入门使用手册

- Radmin 3.5 简体中文版附完美破解 支持

- Radmin 3.5 简体中文版附完美破解

- LoRaWAN1.0.2规范中文完美翻译

- LoRaWAN规范中文版详细规范V1.0.2

- codesys编程手册中文版

- mikrotik_5.X 6.X中文語言包.rar

- Linux操作系统课件PPT

- ANSYS-LS-DYNA使用手册中文指南

- st foc 2.0 中文手册

川公网安备 51152502000135号

川公网安备 51152502000135号

评论

共有 条评论