资源简介

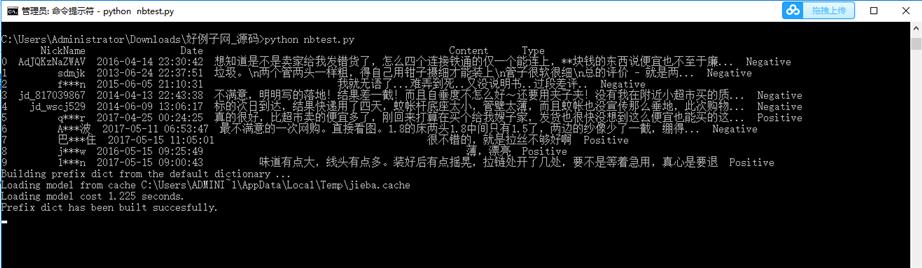

1. 应用朴素贝叶斯算法,对Content 数据集进行分类

1)对数据进行清洗

2)基于给定的词库和停止词,进行文本切词

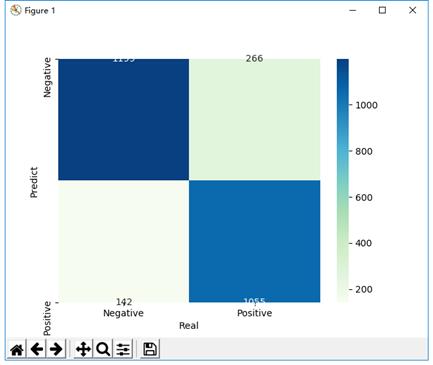

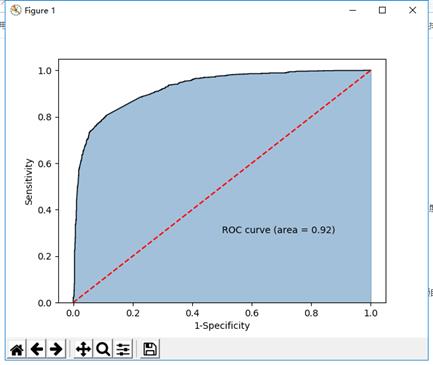

3)建立NB模型

代码片段和文件信息

import pandas as pd

# 读入评论数据

evaluation = pd.read_excel(r‘Contents.xlsx‘)

# 查看数据前10行

print(evaluation.head(10))

# 运用正则表达式,将评论中的数字和英文去除

evaluation.Content = evaluation.Content.str.replace(‘[0-9a-zA-Z]‘‘‘)

evaluation.head()

# 导入第三方包

import jieba

# 加载自定义词库

jieba.load_userdict(r‘all_words.txt‘)

# 读入停止词

with open(r‘mystopwords.txt‘ encoding=‘UTF-8‘) as words:

stop_words = [i.strip() for i in words.readlines()]

# 构造切词的自定义函数,并在切词过程中删除停止词

def cut_word(sentence):

words = [i for i in jieba.lcut(sentence) if i not in stop_words]

# 切完的词用空格隔开

result = ‘ ‘.join(words)

return(result)

# 对评论内容进行批量切词

words = evaluation.Content.apply(cut_word)

# 前5行内容的切词效果

words[:5]

# 导入第三方包

from sklearn.feature_extraction.text import CountVectorizer

# 计算每个词在各评属性 大小 日期 时间 名称

----------- --------- ---------- ----- ----

文件 701641 2019-08-25 09:01 all_words.txt

文件 929935 2019-08-25 09:01 Contents.xlsx

文件 99725 2019-08-25 09:01 mystopwords.txt

文件 3050 2019-09-14 21:07 nbtest.py

----------- --------- ---------- ----- ----

1734351 4

相关资源

- Python-用python3opencv3做的中国车牌识别

- 车牌识别系统_python,opencv

- 基于模糊神经网络的目标自动识别

- 神经网络实现简单的手写数字识别

- dlib_face_recognition_resnet_model_v1.dat人脸识

- 手写数字识别:Python+BP神经网络+PYQ

- 基于卷积神经网络的食物图像识别

- 人脸识别理论和Python实现

- 创建画板,实时在线手写体识别

- 基于傅里叶算子的手势识别的完整源

- face.dat.zip

- poketsphinx的普通话识别模块-cmusphinx-

- 基于python+opencv的目标图像自动识别提

- Python-TensorFlow实现的人脸性别年龄识别

- 利用Python+opencv实时的人眼识别以+眨眼

- 基于python+opencv的目标图像自动识别提

- Python_Dlib_Face_Recognition.zip

- 基于TensorFlow的手写数字识别程序

- 车牌识别Tensorflow_CNN_python_opencv.zip

- 人脸识别源代码及模型

- 人脸情绪识别VS2015python工程

- Python-基于Tensorflow和Keras实现端到端的

- laview_and_python_face_recognition.zip

- python3版 40行代码的人脸识别实践

- Python+opencv实时的人眼识别以+眨眼检测

- 代码:Python+TensorFlow+PyQt实现手写体数

- 基于Python的人脸识别系统

- jieba分词,连接数据库,分析数据库中

- Python实现K-means聚类算法

- 朴素贝叶斯算法实现的文本分类_Pyt

川公网安备 51152502000135号

川公网安备 51152502000135号

评论

共有 条评论