资源简介

最大匹配法分词Python,文档,代码齐全。注释齐全。输入为人民日报标准语料库。10分绝对不亏。

代码片段和文件信息

# -*- coding: cp936 -*-

#最大匹配法进行分词----创建词表文件.

#author 徐能

#date 2013/3/23

import string

import re

#输入:语料库199801.txt文件; 输出:换行分割后的词表文件dict.txt(已经去重复 去日期)

def create_dict(filename):

print(“读取文件......“)

src_data = open(filename‘r‘).read()

sp_data = src_data.split()#分割

print(“原始词数为:“len(sp_data))

set_data = set(sp_data) #去重复

data = list(set_data) #set转换成list 否则不能索引

print(“去除重复后总词数为:“len(data))

print(“正在建立词表文件......“)

tmp = []

for i in range(0len(data)):

if re.compile(r‘\d+\-\S+‘).match(data[i]): #去除类似这样的词‘19980101-01-001-002/m‘

continue

else:

p_ok_data = re.compile(r‘\/\w+‘).sub(‘\n‘data[i]) #将类似的词‘埃特纳/ns‘替换为‘埃特纳‘

if re.compile(r‘(\[\S+)|(\]\S+)‘).match(p_ok_data): #找到以‘[‘或‘]‘开头的词

ok_data = re.compile(r‘(\]\w+\[)|(\])|(\[)‘).sub(‘‘p_ok_data) #去除‘]nt[澳门‘‘]澳门‘‘[澳门‘三类词的头部无用部分(先匹配长的部分)

tmp.append(ok_data)

continue

tmp.append(p_ok_data)

print(“最终得到的词表文件中总词数为:“len(tmp))

open(‘dict_tmp.txt‘‘w‘).writelines(tmp)

print(“初步词表文件建立完成! (dict_tmp.txt)“)

#运行

if __name__ == ‘__main__‘:

create_dict(‘199801.txt‘)

## create_dict(‘testdict1.txt‘)

## create_dict(‘testdict2.txt‘)

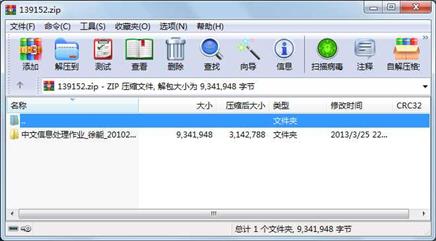

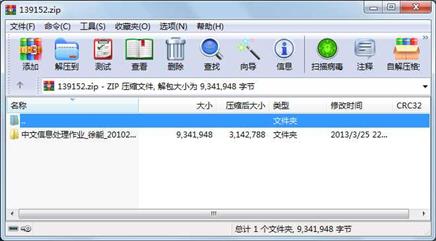

属性 大小 日期 时间 名称

----------- --------- ---------- ----- ----

目录 0 2013-03-25 22:09 中文信息处理作业_徐能_2010241060\

目录 0 2013-03-25 22:10 中文信息处理作业_徐能_2010241060\文档\

文件 103936 2013-03-25 22:00 中文信息处理作业_徐能_2010241060\文档\最大匹配法分词算法分析与说明.doc

目录 0 2013-03-25 22:13 中文信息处理作业_徐能_2010241060\源码\

文件 8830154 2000-12-15 17:03 中文信息处理作业_徐能_2010241060\源码\199801.txt

文件 398406 2013-03-25 22:12 中文信息处理作业_徐能_2010241060\源码\dict.txt

文件 1351 2013-03-25 21:38 中文信息处理作业_徐能_2010241060\源码\MaxBuildDict.py

文件 893 2013-03-25 21:41 中文信息处理作业_徐能_2010241060\源码\MaxBuildDictModify.py

文件 1799 2013-03-25 21:28 中文信息处理作业_徐能_2010241060\源码\MaxWordSegmentation.py

文件 472 2013-03-25 22:35 中文信息处理作业_徐能_2010241060\源码\MaxWordSegmentationTest.py

文件 0 2013-03-17 19:22 中文信息处理作业_徐能_2010241060\源码\__init__.py

目录 0 2013-03-25 22:09 中文信息处理作业_徐能_2010241060\源码\__pycache__\

文件 2003 2013-03-25 22:06 中文信息处理作业_徐能_2010241060\源码\__pycache__\MaxWordSegmentation.cpython-33.pyc

文件 1875 2013-03-22 21:46 中文信息处理作业_徐能_2010241060\源码\__pycache__\other.cpython-33.pyc

文件 146 2013-03-24 20:11 中文信息处理作业_徐能_2010241060\源码\__pycache__\__init__.cpython-33.pyc

文件 913 2013-03-25 22:11 中文信息处理作业_徐能_2010241060\源码\源码运行说明.txt

相关资源

- 二级考试python试题12套(包括选择题和

- pywin32_python3.6_64位

- python+ selenium教程

- PycURL(Windows7/Win32)Python2.7安装包 P

- 英文原版-Scientific Computing with Python

- 7.图像风格迁移 基于深度学习 pyt

- 基于Python的学生管理系统

- A Byte of Python(简明Python教程)(第

- Python实例174946

- Python 人脸识别

- Python 人事管理系统

- 基于python-flask的个人博客系统

- 计算机视觉应用开发流程

- python 调用sftp断点续传文件

- python socket游戏

- 基于Python爬虫爬取天气预报信息

- python函数编程和讲解

- Python开发的个人博客

- 基于python的三层神经网络模型搭建

- python实现自动操作windows应用

- python人脸识别(opencv)

- python 绘图(方形、线条、圆形)

- python疫情卡UN管控

- python 连连看小游戏源码

- 基于PyQt5的视频播放器设计

- 一个简单的python爬虫

- csv文件行列转换python实现代码

- Python操作Mysql教程手册

- Python Machine Learning Case Studies

- python获取硬件信息

川公网安备 51152502000135号

川公网安备 51152502000135号

评论

共有 条评论